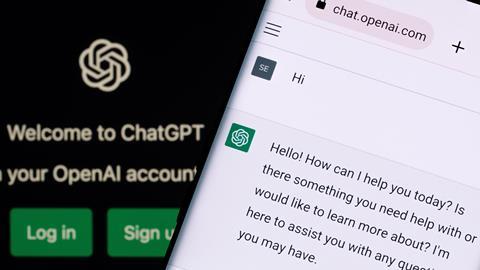

使用生成的影响人工智能(AI)的广受欢迎的ChatGPT等工具研究是一个热点话题的讨论在最近的年度会议的美国科学促进协会(AAAS)在华盛顿特区。OpenAI发起的chatbot,不到五个月前,已被列为几个研究论文的合著者。

今年1月,科学期刊发表的AAAS的家庭宣布了一项全面禁止此类text-generating算法,主编霍尔顿索普表达显著的潜在影响的担忧这些技术可以研究。令人担心的是,假论文写的部分或完全由ChatGPT等项目将会发现他们的科学文献。

今年早些时候一个团队来自美国伊利诺斯州芝加哥大学和西北大学训练ChatGPT作假的研究摘要基于在高影响力杂志上发表论文。他们这些骗子通过剽窃论文和原始的探测器和AI输出探测器,和分别生成人评论家试图区分哪些是,哪些是真实的。

在这项研究中,剽窃监测工具无法区分真实和虚假抽象,但免费工具像GPT-2输出检测器能够成功地确定文本是由一个人类或机器人。然而,人类的评论者只能认识到ChatGPT-generated论文68%的时间,他们错误地认为14%的真正的抽象是假药。

这些发现促使科学出版商采取行动。施普林格自然也修改了其规则来指定技术像ChatGPT不能作为一个作者可以使用,但它们在制备过程中只要所有细节透露。

荷兰学术出版巨头爱思唯尔发表了指导AI工具可以用来改进的“可读性”和语言传播的研究文章,这是提供披露。但爱思唯尔出版超过2800种期刊,禁止使用这些技术等关键任务解释数据或当写结果得出的科学结论。爱思唯尔确实允许人工智能研究设计工具的使用,然而。

“疯狂的”

在AAAS媒体对这些技术简报,索普说ChatGPT和类似的人工智能聊天机器人很多的潜力,但他强调景观是动态的。我们疯狂的现在,我不认为疯狂的中间是一个很好的时间来做出决定,”索普说。我们需要利益相关者之间的对话,我们将争取这样的工具。

他描述了科学的使用ChatGPT政策及其兄弟姐妹的最保守的方法由科学出版社。一旦这一切,我们得到最终死亡,我们有一个深思熟虑的讨论这个问题,可能会有一些方法来使用它将被科学界接受,”索普说。

他做了一个类比这些新生成人工智能技术和Adobe Photoshop,几十年前当它第一次出现。人们做的东西来改善他们的图片看起来的方式,主要是聚丙烯酰胺凝胶,然后我们没有护栏,”索普回忆说,指出科学界争论是不是不合适从1990年代末到2010年左右。“我们不想再重复一遍,因为占用了大量带宽的科学…我们不想争论的老作品。”

索普承认,然而,他的组织是收到很多反馈,已经走得太远。但它是更容易放松你的标准比收紧他们,”他说。

Gordon Crovitz的联席首席执行官Newsguard -新闻和技术工具,新闻的可信度和跟踪在线错误——在AAAS事件更进一步。他说他认为ChatGPT目前的形式最大的潜在的错误撒布机的历史世界”。

聊天机器人的访问世界上每一个错误的例子,它能够传播雄辩地高度可信的,完美的英语,以各种各样的形式”,他警告说,后来版本的工具像微软的Bing聊天已经为读者提供训练更为平衡的帐户和引用它的来源。

Crovitz讲述了他如何利用ChatGPT起草一封电子邮件Sam Altman OpenAI的首席执行官。提示他聊天机器人是奥特曼发送电子邮件说为什么这个工具应该被训练理解新闻来源的可信度和识别虚假的故事。

这产生了最精彩的电子邮件,我透露,ChatGPT合著者,并写信给他:“亲爱的山姆,你对我的服务非常有说服力,希望它会对你有说服力,”并附加机器创造了对我来说,‘Crovitz回忆道。他说,他仍在等待奥特曼的答复。

同行评审可以颠覆?

不仅有在研究团体的关注ChatGPT已被接受作为一个作者在多个研究论文,但也有质疑这项技术能否颠覆同行评审过程。

安德鲁•白化学工程和化学教授在纽约罗切斯特大学,最近Twitter寻求建议在收到一个他所形容的五句,非常非特异性同行评审的研究论文。ChatGPT探测器使用白色报道,审查可能由人工智能,他想知道该怎么做。别人插话说类似的事情发生。

我去推特,因为没有确凿的证据,并回顾unaddressable,“白告诉必威体育 红利账户化学世界。这是新的地面——如果你说抄袭同行审查,没有机制来解决这个问题,”他继续说。“我想宁可谨慎,所以我跟编辑说评论是不寻常的和非特异性,不管作者,它不是可寻址。

同行评审不支付或有外部识别,白人笔记和指出,这同样适用于机构的年度报告,美国研究人员必须写基金。这些报道消失的地方,没人读,我相信人在写那些ChatGPT,”White说。

期刊必须评估研究论文和同行评论家的评论更仔细一定要抓住任何表面,可能是人工智能所写,他说。也许这将减缓发布,也许这就是我们需要的。”

更新:2023年3月21日通过爱思唯尔的禁止人工智能工具是澄清指出,出版商允许使用这些工具进行研究设计

还没有评论