在3月中旬,一个一分钟的视频乌克兰总统之上Zelenskiy出现在社交媒体上,后来在乌克兰新闻网站。,Zelenskiy告诉乌克兰士兵放下武器,向俄罗斯军队投降。但是,视频原来是一个deepfake,一块合成媒体由机器学习。

现在一些科学家担心类似的技术可以用来提交创建假的图像光谱或欺诈的研究生物标本。

我一直非常担心这些类型的技术,”微生物学家和科学完整的专家说伊丽莎白Bik。我认为这种情况正在发生——创建deepfake图片和发布(他们)。”她怀疑的图像超过600完全捏造研究她帮助揭开,可能来自相同的造纸厂,可能是AI-generated。

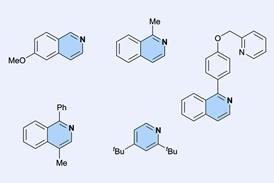

与手动操作图像,AI-generated可以几乎不可能发现的眼睛。在同行评议的案例研究,计算机科学家领导的研究小组Rongshan余从厦门大学在中国创造了一系列deepfake免疫印迹和癌症的图像。三分之二的生物医学专家都无法区分真正的事情。

问题是,deepfake图像是独一无二的,Yu说。他们没有人们通常寻找痕迹——重复元素和背景不一致,例如。此外,“deepfake和其他工具现在高可用性”,Yu说。这不是火箭科学,你不需要一个高级人工智能专家使用它们。”

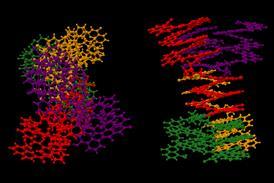

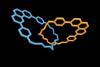

Deepfakes往往基于生成对抗网络(甘),发电机和鉴别器试图战胜对方。“一个网络试图从白噪声生成一个假的形象,比方说,“deepfake技术研究员解释道约翰(Saniat) Sohrawardi罗切斯特理工学院的我们。“它不知道如何生成一张脸最初,所以需要一个鉴别器的帮助下,这是另一个网络,学习如何分辨一个图像是真实的还是假的。“最终,发电机将傻瓜鉴别器认为它的图片是真实的。

鉴于甘斯可以合成的脸无法区分真正的吗,“我不认为它应该是一个冲击,它可以生成这些类型的相当平凡的生物图像”,说Hany Farid,专攻数字取证和错误信息在加州大学伯克利分校在美国。虽然deepfakes威胁被认真对待,“我更担心再现性,p黑客Photoshop处理——老学校的东西,仍然会,我怀疑,主宰了好一阵子。”

马修·赖特罗彻斯特的全球网络安全研究所主任对此表示赞同。“我不觉得这是特别威胁,尽管技术上很可能,很难发现如果有人做到了。”

数字机器学习留下的文物可以用来识别假图片,解释说,虽然骗子通常找到一种方法在这些方法仅仅几个月后。”最后,唯一能解决问题的是活跃的,验证与硬加密的记录,”他说。他相信科学的自我调节机制最终将处理假的研究。

Yu说,还不清楚文献已经包含AI-generated图像。我认为我们已经达到了顶点,我们再也不能判断是真实的还是假的,'说Bik .我们需要更加努力地工作与机构…承担部分的责任,”她建议,并带走压力从研究者的整个职业生涯可能取决于被发表在国际杂志上。

引用

L王等,模式,2022,3,100509 (DOI:10.1016 / j.patter.2022.100509)

还没有评论