科学研究通常进行最好的意图——不管它是改善健康状况,提供清洁能源,或者增加了解我们周围的世界。但是如果你的工作可能会故意误用造成伤害?

这个问题成为了关注的焦点,研究人员在药物发现公司在北卡罗莱纳,我们。制药公司的团队协作被邀请参加一个会议,要求科学家试图识别潜在的威胁可能来自他们的工作。

在科学界有一个盲点

法比奥·乌尔比纳,制药公司的合作

的想法是这化学战争防御工作的人能够了解新事物并不是措手不及,如果一些新的技术出来六个月前被用于某些目的滥用,”解释道法比奥·乌尔比纳资深科学家合作。

合作医药使用人工智能工具来识别潜在的治疗罕见疾病。预测分子可能在人体内,影响团队花很多时间造型的已知化合物的性质建立构效关系。

他们分析最重要的一个特征是毒性,无论多么好的一个分子是在治疗疾病症状,也不会让一个合适的药物,如果产生致命的副作用。“如果我们可以通过预测几乎屏蔽分子是否它们是有毒的,我们可以开始一个更好的候选药物组的,“Urbina)说。

当他们被邀请去参加Speiz收敛会议,最初Urbina)和他的同事们困惑的关于他们的技术可能被那些想要造成伤害——毕竟,他们的工作的重点是创建新药物。但它明白了他们复杂的毒性模型可能被滥用的团队伤害人。

我们通常做一些组合:我们想要抑制这种特殊的蛋白质,将治疗,但我们也希望不会有毒。,一般进入我们的大多数衍生设计,解释了乌尔比纳。但在五分钟的谈话,我们意识到,我们不得不做的基本上是抛在我们的代码不平等的象征,而不是给一个较低的分数为高毒性预测分子,我们给它一个高分数预测毒性。

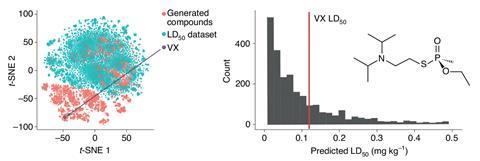

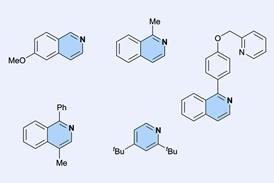

测试这个想法,协作团队决定屏幕的化合物可以抑制乙酰胆碱酯酶的酶,这有助于打破神经递质乙酰胆碱-肌肉放松的重要过程。同时针对乙酰胆碱酯酶酶可以治疗一些疾病的治疗,在一定的剂量,它也是神经毒气的目标VX。

讨论这个想法后,乌尔比纳设置搜索他的电脑,把它一夜之间运行。我早上回来,我们有1000年代产生的这些分子,”他说。当研究人员分析了分子预测最接近匹配的搜索查询,他们看到几个化合物的化学结构相似VX。

”,更糟糕的是,相当多的人更比VX的毒性预测——这是一个非常令人惊讶的结果,因为VX通常被认为是最有效的毒药之一存在,“Urbina)说。所以的东西比VX引发了一些强有力的警报在你的脑海中。

“很明显,将会有一些假阳性在这些预测,他们不完美的机器学习算法,”他补充道。但里面的东西的机会比VX的绝对是一个真正的可能性。”

随着团队挖掘深入他们的恐惧被证实当一些人工智能工具生成的分子被发现已知的化学战剂。“这告诉我们,我们在正确的空间——我们并没有产生疯狂,奇怪的事情,但是,我们的模型已经拿起什么是重要的对于这种类型的毒性。”

道德风险

Urbina)和他的同事们,实验强调道德问题也许并不总是给予足够的认为在设计新的化学软件。他们指出,尽管他们使用的机器学习算法可以帮助坏演员发现有害的新分子,其他类型的AI像retrosynthesis工具还可以帮助用户实际上使材料。这些系统甚至可以帮助用户避免原料政府观察名单。

我们真的找不到任何评论或使用机器学习道德准则在化学空间。这有点奇怪,因为我们认为会有一些,但没有,说乌尔比纳。”,让我们有点落伍的。”

Urbina)指出,在人工智能研究的其他领域一样,道德往往得到更多的关注。”,一些最新的语言模型出来——在他们的论文,他们讨论一页半长,特别关注滥用,”他说。我们一无所有我所见过的那种,我从没见过化学论文使用机器学习,产生一些毒性领域,有重点部分讨论如何可能被滥用。

日常用品Avin风险缓解策略专家基于剑桥大学研究中心的生存风险,说他更惊讶有多少合作研究人员的报告似乎震惊了药物发现比发现自己的社区。如果你已经有一个大型数据集的化合物,注释与特性,如毒性或疗效目的X -和实际预期的预测是基于这些特性有现实世界的相关性…然后切换来预betway必威游戏下载大全测另一个特性,如最大化毒性,应该是一个相当自然的“红色团队”实验中,“Avin说。”,这是一个事后的团队发现这表明远远落后于我们的灌输一种文化或责任在实践中创新。

红色团队实验Avin指的是一个练习,旨在揭露软件中的漏洞和警报程序员的系统可能被滥用。它是之一维护措施他建议AI开发者来确保他们的技术设计负责。

英国人工智能的机器智能车库加速器我建议,所有的创业公司都要经历一个道德咨询项目,在他们的第一个星期,他们正面临着这样的问题:“你的技术如何被滥用?你将如何减轻这样的滥用?“‘Avin说。”很明显,之前还有许多工作需要做这样的问题被要求在所有AI-enabled公司和部门,但我们应该期待。”

滥用科学

虽然它可能会认为访问合作开发的工具,像那些制药公司应该限制,以避免最坏的场景,Urbina)指出,他的研究小组提出的问题的实验很难解决,特别是考虑到基本的透明度和科学数据共享的重要性。我们所有关于数据资源共享,我非常支持推出数据集可以使用在可能的最佳方法的研究,”他说。”甚至最新的(美国国立卫生研究院)指南出来有一个巨大的关注数据共享。但没有一个单一的句子或部分如何,新的共享数据可能被滥用。所以对我来说,它只是告诉我,有一个盲点在科学界。

前进,Urbina)说,他计划包括一个讨论误用在他所有的论文,并希望在未来可能成为常态研究者期望这种对话在学术文章。

协作小组还建议大学应该加强科学和计算学生的道德培训,并希望AI-focused药物发现公司的行为准则达成一致,将确保适当的培训的员工和维护安全的技术措施。

杰弗里·科瓦克美国田纳西州大学的化学家,他写了大量有关科学伦理,认为所有人员必须做他们的最好预测后果——两个好的和坏的——他们的发现的。然而,他指出,许多例子在历史显示困难的可以预测的结果。“一个是含氯氟烃制冷剂(氟氯化碳),”他说。”这些都是当时的一大进步,因为他们取代氨,但后来我们得知,他们负面的环境影响。”

科瓦克不相信人工智能的出现一定变化太多,注意的是,“好合成化学家已经设计新的分子很长一段时间”。“目前化学武器非常有毒,”他说。所以目前还不清楚是否设计更多的有毒物质使定性的差异。但他与协作团队的要求更强调道德教育科学学生。

“我也建议化学社会的伦理准则,以及计算机科学,需要加强,更加重视需要处理的问题,当今世界,”他补充道。

引用

F·乌尔维纳等,Nat,马赫。智能。,2022,DOI:10.1038 / s42256 - 022 - 00465 - 9

还没有评论