大型语言模型可以为化学强大的工具,如果我们承认他们的限制

在在医药化学技术的作用,目前是不可能逃避讨论大型语言模型(LLM) ChatGPT。这个chatbot迅速成为有史以来增长最快的消费应用,明显的让谈话(松散定义)人工智能访问任何人。我和现有注册谷歌帐号,聊起来可以聊天机器人通过输入简单的英语网站。ChatGPT也是非常强大的。它可以总结长文本或挖出特定的信息,给建议的语气在邮件,编辑或编写代码,使项目建议,或者做任何你让它——只要你接受,答案可能是错的。结合电力和可访问性使得机器人最新技术炒作。

科技爱好者将熟悉Gartner炒作周期,一定程度的兴奋性任何新的发展。通常情况下,一旦一个突破成为流行,紧接着就会有炒作的峰值和过高的期望,往往由于营销人员试图赚钱。有一个淘金潮的感觉,每个人都试图得到船上,因为他们不想被落在后面。但当人们承担新工具为错误的原因,或用例自然不行,幻灭的高峰让位给一个低谷。用户感到失望它并没有改变世界,让他们同时一杯茶,和公司依靠科技可能会失败。最后,如果技术实际上是值得它最终达到常态高原没有多余的幻灭也没有过分激动。

Gartner炒作周期是主观的,点击不同的用户在不同的时间,实际上也不是一个周期。然而,一旦一个工具已经达到炒作高峰,这不是一个坏的观察,从心理上来说,接下来会发生。

学术科学家,他们可能受益于最初的围绕一个大纸但不一定需要工作变成长期价值,生成和使用炒作可以让事业。当大型技术,它可以价值数十亿。学者和科技公司,许多可能觉得他们的目标的成功超过过分吹嘘的投诉的成本,即使实践是道德问题。

炒作掩盖了,llm实际上远远超过聊天机器人

说技术或论文是表明有些亢奋的一部分应该好处比物质更绒毛(最多),或积极错误的或有害的(在最坏的情况)。当然ChatGPT犯错。我奇怪喜欢探索其功能的极限。例如,它有一些化学知识,但缺乏仅限于本科生早期化学转换——这并不奇怪,考虑到订阅付费墙背后最先进的见解都被锁了起来。有时它可能是正确的只有幸运的机会。当我问它显示为一个假设的铃木耦合反应条件确实很好,但是当我将扩展到其他催化反应我意识到它建议相似条件的转换。有时它可以完全是错误的:当我问ChatGPT向我展示一些论文我写的,我学习我的惊喜自然在电致发光材料,哪些字段我基本上一无所知。

我还有很长一段参数与机器人是否螺旋手性:一个简单的请求,只手性分子相关的事实。因为它感觉就像text-chatting人类,我本质上浪费时间的教学工具,不能教,它也固执的感觉令人难以置信的令人沮丧但争辩的能力提供持续的冲动。

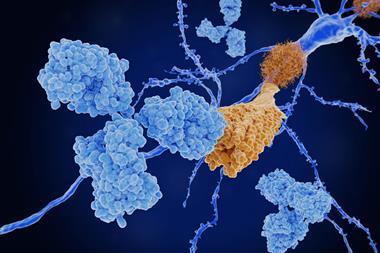

炒作掩盖了,llm实际上远远超过聊天机器人。以编程方式访问时,他们可以复杂的图形和数据库知识和许多类型的实体之间的联系。或者,他们可以用先进的领域知识,专用和预调准备挑选连接困难或太耗时deconvolute人类。预先调谐还可以极大地减少幻觉就像我不存在的风险自然纸。可以告诉一个模型来限制其应对那些来自一个特定的语料库(例如,一个公司的药物发现知识库),并提供支票来源。尽管公众ChatGPT也是强大的,定制的模型可能是一个改变游戏规则对许多化学数据的使用。

我真的朝前看,发现llm将制药和化学。他们变得更令人印象深刻的月,保障措施和一些常识,他们的权力迅速放到有关信息和产生输出令人印象深刻。至于公众版,一旦我获得更高级的GPT-4,我问的第一个问题是是否螺旋手性。甚至没有丝毫的犹豫,它正确地回答是的。

还没有评论