我们期望学生什么?

二十年前,也许我的朋友托马斯正在他的博士论文在量子引力。他有一些非常复杂的方程来解决和开始使用一个软件应用程序,允许高级代数操作。托马斯在几秒钟可以解决方程,带上纸和笔,他天少犯错误的机会!

但托马斯的主管不满意自己的自动化解决方案。他声称他不可能依靠计算机的答案。然而,我怀疑他有一个未表达的道德异议,认为使用电脑来解决问题是作弊。最后,主管妥协:托马斯可以使用应用程序,但必须验证每个答案的传统方法。经过几个月的突出进展,主管他的需求下降,和托马斯是完全免费的依赖电脑。

这个小戏剧是世代焦虑——每一代的感觉,下一个是错误的。

我们正处于边缘的一个巨大的代际焦虑来源:AI-generated文本。我们已经将我们的工作外包给机器(如托马斯和他的方程)几十年了。尽管如此,我们已经开始让那些机器第一次写作过程。我们将最大的革命经验知识生产发明以来,写作。如果我们没有焦虑,我们就是傻瓜。

ChatGPT是一种复杂的语言模型,该模型可以生成自然语言反应用户提示。训练在大量的文本数据使用人工智能被称为深度学习的一种形式。结果,ChatGPT可以提供范围广泛的主题和从事信息与用户友好的对话。更重要的是,它产生的文本是类似于人类可能会写什么。

没有人能迫使精灵瓶子:人工智能文本仍然呆在这里

学生将使用ChatGPT和其他人工智能工具来写他们的论文,研究论文和个人陈述。检测软件的小型产业已经形成。然而,AI-text探测器容易出现假阴性,更糟的是,假阳性。

即使AI-text检测工作,需要多长时间,直到下一个人工智能语言模型打败吗?我们真的想要拖进这样的军备竞赛吗?

和许多人一样,我也关心AI文本的不可预见的后果。低语,是错误的;这是作弊。也许最让我害怕的是什么是人工智能文本可能呈现写作技巧一样过时的知道如何使用日志表乘法。

但我想是豁达,不消退世代焦虑。没有人能迫使精灵瓶子:人工智能文本仍然呆在这里。我们快速走向未来的个人电脑助手迅速回答任何我们的请求。这是美妙的!

我不应该担心学生们会滥用它。我应该高兴的新途径这些工具将打开他们的生活和事业。我应该接受的方式衡量对错在知识生产很快就会过时。

关键问题困扰许多是否正确,声称一个人工智能的文本的作者。从任何合理的身份定义,答案显然是否定的。

然而,一个更合适的问题可能会声称作者知识的工作报告是否通过一个AI文本是正确的。

然后,我更愿意说是。

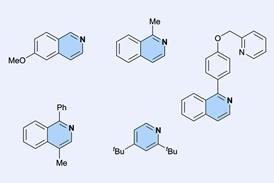

当代知识通常比写作更工作。它需要范本,方法设计和调查。我们必须处理数据管理,验证和可视化。我们应该确保资源和软件是可用的。任何项目水槽如果不能依靠资金、管理和监督。如果一切顺利,我们将最后写。

有这么多活动,毫不奇怪,许多知识已经成为一个集体企业工作。你可以合法是一篇论文的作者没有导致其写作。

事实上,许多学者和学术出版商使用分类系统(或贡献者的角色信贷),它定义了14个角色通常由研究人员。如果分配给任何一个人被认为是作者的角色。如果我们接受一篇论文的作者之一,有人可以另一个人写道,他们为什么不能是一篇论文的作者写的一个人工智能吗?

而不是战斗AI技术,我们应该接受它,帮助下一代的道德和最佳使用它。实际上,我们可以教学生最重要的教训是责任。如果他们签写的一篇文章——不管他们,合作者或人工智能——他们会自动对其内容负责。如果它是错误的或导致身体损害,经济损失或道德的伤害,他们不能索赔的无知。

房间里的人是一个角色不能放弃。

还没有评论